Burbuja de filtros, cámara de ecos o radicalización algorítmica: ¿A cuál de ellos te han llevado tus redes?

MUNDOS PARALELOSGRETEL QUINTERO ANGULO

Pensándolo un poco, me di cuenta de que esto ya lo había vivido en otras redes, como Facebook o Instagram. Después de ver por casualidad, no sé, un video sobre decoración de jardines y darle like, mi feed comenzaba a llenarse de publicaciones sobre ese tema, aunque no interactuara con ninguna otra. Y prestando un poco más de atención, noté que, en algún momento que no recordaba, y salvo algunas publicaciones puntuales, mis feeds en redes sociales se habían vuelto predecibles y monótonos. Contenían muchísimas publicaciones que no solo pertenecían a un conjunto bien establecido de temas, sino que, además, todas decían más o menos lo mismo.

Para mi sorpresa, hace unos días descubrí que este fenómeno ya ha sido estudiado y hasta tiene nombre: burbuja de filtros, y que está además muy relacionado con otros dos efectos negativos que se están dando cada vez más en redes: la cámara de ecos y la radicalización algorítmica.

Burbuja de filtros, cámara de ecos y radicalización algorítmica

El término burbuja de filtros fue acuñado por Eli Pariser en 2011 para describir cómo los algoritmos de recomendación en internet (como los de Google, YouTube, Facebook, TikTok, etc.) personalizan el contenido que ves según tus intereses y comportamiento previo. En principio, esto facilita la navegación dentro de la enorme cantidad de contenido disponible cada día. Sin embargo, también reduce la diversidad de información a la que estamos expuestos. Esto limita nuestras posibilidades de descubrir nuevas perspectivas y nos hace más propensos a caer en una cámara de eco, es decir, a interactuar solo con contenido o personas que refuerzan nuestras opiniones sin desafiarnos con visiones diferentes.

Estos fenómenos ocurren tanto por el diseño de los algoritmos, que buscan retener la atención del usuario favoreciendo contenido que genera mayor interacción, como por la tendencia natural del ser humano a buscar la validación de sus creencias. Ambos factores refuerzan los sesgos de confirmación, creando una visión limitada de la realidad, reduciendo el pensamiento crítico y promoviendo el consumo excesivo de redes sociales.

Asimismo, las burbujas de filtros y cámaras de eco afectan a los creadores digitales. Dado que los algoritmos priorizan contenido alineado con intereses específicos, los creadores nuevos o con enfoques distintos tienen dificultades para ampliar sus audiencias. A su vez, para mantener altos niveles de visibilidad, muchos se ven presionados a seguir las tendencias y producir contenido similar al que ya saben que funciona, lo que homogeniza el discurso. Además, pueden sentirse incentivados a generar contenido cada vez más extremo o sensacionalista para captar más la atención.

Un ejemplo muy actual de esta homogeneización y sensacionalización de los contenidos son los cientos de críticas a la película Emilia Pérez que pululan por YouTube. Demuestran cómo, en una plataforma que supuestamente ofrece un espacio para la democratización del discurso, se puede lograr una avalancha de repetidores. Es decir, “creadores” cuyos videos de creación no tienen nada, ya que solo repiten punto por punto lo que han dicho otros. Al extremo de parecer que, de alguna manera, se ha formado un guion consensuado, donde hay tres o cuatro puntos clave, con sus respectivas ideas y shorts de la película, que conforman los aspectos criticables de esta. Ninguno —salvo el primero que la criticó, que sabrá Dios quién fue— aporta nada nuevo a la valoración, a pesar de que muchos dicen tener supuestos estudios sobre comunicación, cine, etc. Al mismo tiempo, con el paso de los días, las críticas se volvían más violentas, y los críticos parecían más ofendidos por la película. (Sí, fue en estos días de la crítica a Emilia Pérez que mi tolerancia a la burbuja de filtros explotó, así como mi paciencia hacia los creadores que no crean).

En su expresión más extrema, la combinación de la burbuja de filtros con la cámara de ecos podría llevar a lo que se conoce como radicalización algorítmica, es decir, a la tendencia a consumir contenido progresivamente más extremo y a la creación de comunidades cerradas con opiniones altamente polarizadas. A pesar de su nombre, y como ya se mencionó antes, esta radicalización no es solo resultado de los algoritmos, sino también de la conducta del usuario, quien, en la búsqueda de validar sus opiniones, podría caminar a pasos firmes hacia la polarización. Y aunque los estudios acerca de si los algoritmos nos conducen de manera inevitable o no a la radicalización aún son inconclusos, todo indica que este mecanismo al parecer depende del tema y que funciona especialmente cuando se trata de posiciones políticas.

En el caso de la radicalización algorítmica, algunos usuarios, al ser expuestos a contenido progresivamente más extremo, pueden llegar a aceptar o apoyar ideas muy radicales como si fueran la norma. Por otra parte, el consumo constante de contenido sensacionalista puede aumentar la ansiedad, el estrés y la desconfianza hacia instituciones o comunidades. Asimismo, la producción de este contenido altamente polarizado o alarmista puede llegar a promover creencias erróneas, amplificando información falsa o teorías de conspiración, y afectando la capacidad de los consumidores para discernir entre contenido verídico y engañoso.

Curiosidad, consumo responsable de la información y pensamiento crítico

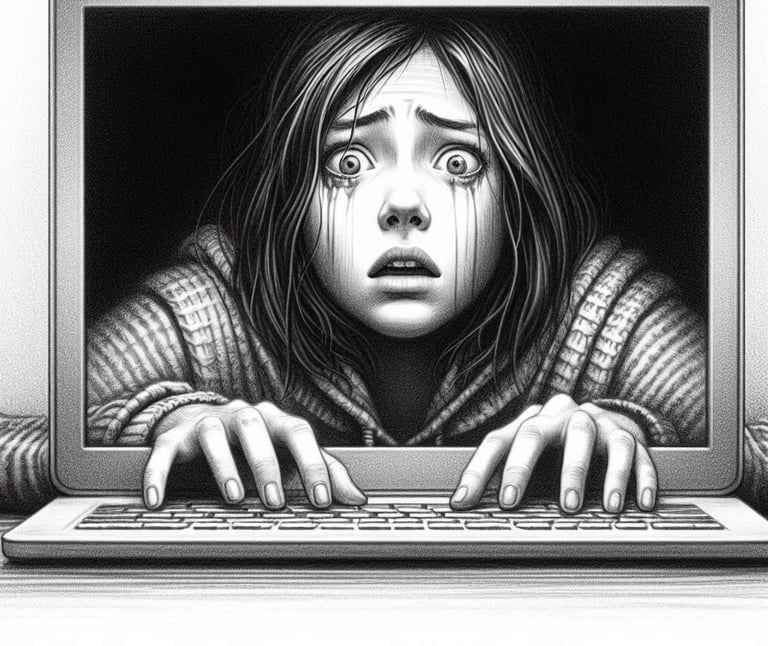

El peligro de quedar atrapado en una burbuja de filtros es mayor mientras más pasivo sea nuestro consumo de contenido. Si nos dejamos llevar solo por lo que las redes recomiendan, el abanico infinito de posibilidades que prometen se vuelve cada vez más cerrado, aburrido y repetitivo. Pero este espacio monótono también puede sentirse cómodo y seguro, haciéndonos vivir —valga la redundancia— en nuestra propia burbuja.

La tentación es grande, pero los riesgos para nuestra capacidad crítica y salud mental también lo son. Así que más nos vale ser conscientes del algoritmo y no dejarnos llevar por la emoción de ver nuestras ideas reforzadas una y otra vez. No escuchar solo lo que queremos oír puede ser clave para no ser manipulados, pero no siempre es fácil. Hay que abrirse a lo bueno y lo malo del mundo, y sobre todo, no limitarse uno mismo.

Por ello, aquí van algunos consejos para evitar caer en la burbuja de filtros:

Sigue fuentes de información variadas y verificables.

Busca activamente contenido fuera de tu zona de confort.

Limpia tu historial y usa el modo incógnito para búsquedas.

Reconoce los patrones de las tendencias y no consumas un mismo tipo de contenido de manera excesiva.

Contrasta el contenido que coincide con tu opinión con aquel que la desafía.

Y si te ha interesado el tema y quieres profundizar más, aquí tienes algunos artículos y estudios académicos por los que puedes comenzar:

📌 "Algorithmic Extremism: Examining YouTube's Rabbit Hole of Radicalization"

📌 "Sesgos algorítmicos en las redes sociales"

📌 "Miedo (in)fundado al algoritmo: Las recomendaciones de YouTube y la radicalización"

📌 "YouTube y la radicalización: qué hay detrás de su algoritmo"

📌 "Aprenda sobre la radicalización"

Cuando empecé mi vida en YouTube, Amazon Prime, Spotify, etc., me encantaba el hecho de que, luego de seleccionar un video, un podcast o una canción, sus algoritmos comenzaban a recomendarme otros muchos que me gustaban. Descubría nuevas canciones, series y películas, o recordaba algunas que había disfrutado en su momento, pero ya había olvidado.

Sin embargo, poco a poco, la situación comenzó a volverse extraña. A veces, luego de ver, por ejemplo, un filme de ciencia ficción, solo me aparecían en las recomendaciones de Amazon Prime películas de este género. O después de escuchar varios capítulos de un podcast de True Crime que adoro, Spotify empezaba a sugerirme exclusivamente contenido de ese tema.